ยุค AI ทำให้การสร้าง-กระจายข่าวปลอมเร็วและเนียนขึ้น แต่ AI ก็เป็นเกราะป้องกันได้เช่นกัน บทความนี้สรุปความเสี่ยง เครื่องมือ และแนวทางรับมือแบบเป็นระบบสำหรับองค์กรและบุคคล.

บทนำ: ทำไมยุค AI ต้องระวัง

AI รุ่นใหม่สามารถสร้าง สื่อสังเคราะห์ (synthetic media) ทั้งข้อความ รูป เสียง วิดีโอ ที่เหมือนจริงมากภายในไม่กี่วินาที ขณะเดียวกันอัลกอริทึมบนแพลตฟอร์มหรือบอทก็ช่วยเร่งการแพร่กระจายได้แบบทวีคูณ จึงเกิดความท้าทายด้าน ความน่าเชื่อถือของข้อมูล และความปลอดภัยเชิงข้อมูล (Information Resilience) ที่ทุกคนควรรู้เท่าทัน

- ข่าวปลอมถูกผลิตได้ “ปริมาณมาก-เร็ว-แพร์สันนาไลซ์” เข้ากับความเชื่อของกลุ่มเป้าหมาย

- Deepfake ทำให้หลักฐานภาพ/เสียงไม่น่าเชื่อถือเหมือนเดิมอีกต่อไป

- อัลกอริทึมคัดเนื้อหา (feed) อาจสร้าง filter bubble ทำให้เห็นมุมเดียวจนเชื่อผิดๆ

เป้าหมายของ Disinformation Security ไม่ใช่กำจัดข่าวปลอมจนหมดสิ้น แต่คือการ 'ลดผลกระทบ' ด้วยการตรวจพบไว ตอบสนองไว และสื่อสารอย่างโปร่งใส

ความรู้พื้นฐานที่ควรเข้าใจ

- Misinformation: ข้อมูลผิดพลาดโดยไม่ตั้งใจ

- Disinformation: ข้อมูลเท็จที่ถูกสร้าง/แพร่โดยเจตนา

- Malinformation: ข้อมูลจริงแต่ใช้ผิดบริบทเพื่อทำร้าย

- สื่อสังเคราะห์ (synthetic): ข้อความ/ภาพ/เสียง/วิดีโอที่ AI สร้างขึ้น (เช่น deepfake)

- การพิสูจน์ที่มา (provenance): เมทาดาทา, ลายน้ำดิจิทัล, หรือตรารับรองเนื้อหา

Disinformation Security คืออะไร?

Disinformation Security คือแนวทาง ป้องกัน-ตรวจจับ-ตอบสนอง ต่อข้อมูลเท็จที่ถูกสร้างขึ้นอย่างจงใจเพื่อบิดเบือนความคิดเห็นหรือพฤติกรรมของสังคม/ลูกค้า โดยเชื่อมกับสาขา Cybersecurity และ Information Security เพื่อคงไว้ซึ่งความน่าเชื่อถือของข้อมูลและแบรนด์.

AI กับข่าวปลอม: ดาบสองคม

- สร้าง (Offense): LLM สร้างบทความ/แชตปลอม, โค้ดบอทโพสต์อัตโนมัติ, Deepfake เสียง/วิดีโอ, และคอนเทนต์เฉพาะบุคคลเพื่อโน้มน้าว

- ป้องกัน (Defense): ระบบตรวจจับ Deepfake, fact-check อัตโนมัติ, content moderation, และ threat intelligence หา pattern การปล่อยข่าวปลอม

เวกเตอร์การโจมตีที่พบบ่อย

- Botnet โซเชียล: บัญชีปลอมจำนวนมากสร้างกระแส/แฮชแท็ก

- Spear-influence: เจาะกลุ่มย่อยด้วยข้อความเฉพาะบุคคล (micro-targeting)

- Synthetic media: ภาพ/เสียง/วิดีโอ deepfake เพื่อทำลายความน่าเชื่อถือ

- ข้อมูลจริงแต่ใช้ผิดบริบท (malinformation): หลุดเอกสาร/คลิปตัดต่อบริบท

ข้อควรระวัง/กับดักที่เจอบ่อย

- หัวข่าว/ภาพกระตุ้นอารมณ์จัดๆ (โกรธ กลัว ตื่นเต้น) เพื่อให้แชร์ก่อนคิด

- ภาพ/คลิป out-of-context — เกิดจริงแต่คนละเวลา/สถานที่ ถูกนำมาปนประเด็น

- สวมรอยบัญชีทางการ (impersonation) โลโก้เหมือน ชื่อไกล้เคียง

- ภาพสกรีนช็อตไม่มีแหล่งที่มา—ตรวจไม่เจอที่ต้นทาง

- ลิงก์พาออกนอกแพลตฟอร์มไปยังกลุ่มปิด/เมสเสจส่วนตัวเพื่อหลอกต่อ

- โพล/กราฟปลอม ใช้สเกลหรือแกนหลอกตาเพื่อชี้นำความเห็น

หลักจำง่าย: ยับยั้งอารมณ์ → ตรวจที่มา → เทียบหลายแหล่ง → มองหาแรงจูงใจ ใครได้ประโยชน์จากการที่คุณเชื่อ/แชร์เนื้อหานี้?

ผลกระทบต่อธุรกิจและสังคม

- แบรนด์ดิ่ง: ข่าวปลอมทำลายความไว้วางใจและยอดขาย

- ความเสี่ยงตลาดทุน: ข่าวลือ/โพสต์หลอกลวงกระทบราคา

- ความมั่นคงสาธารณะ: ข่าวเท็จช่วงวิกฤตทำให้สังคมตื่นตระหนก

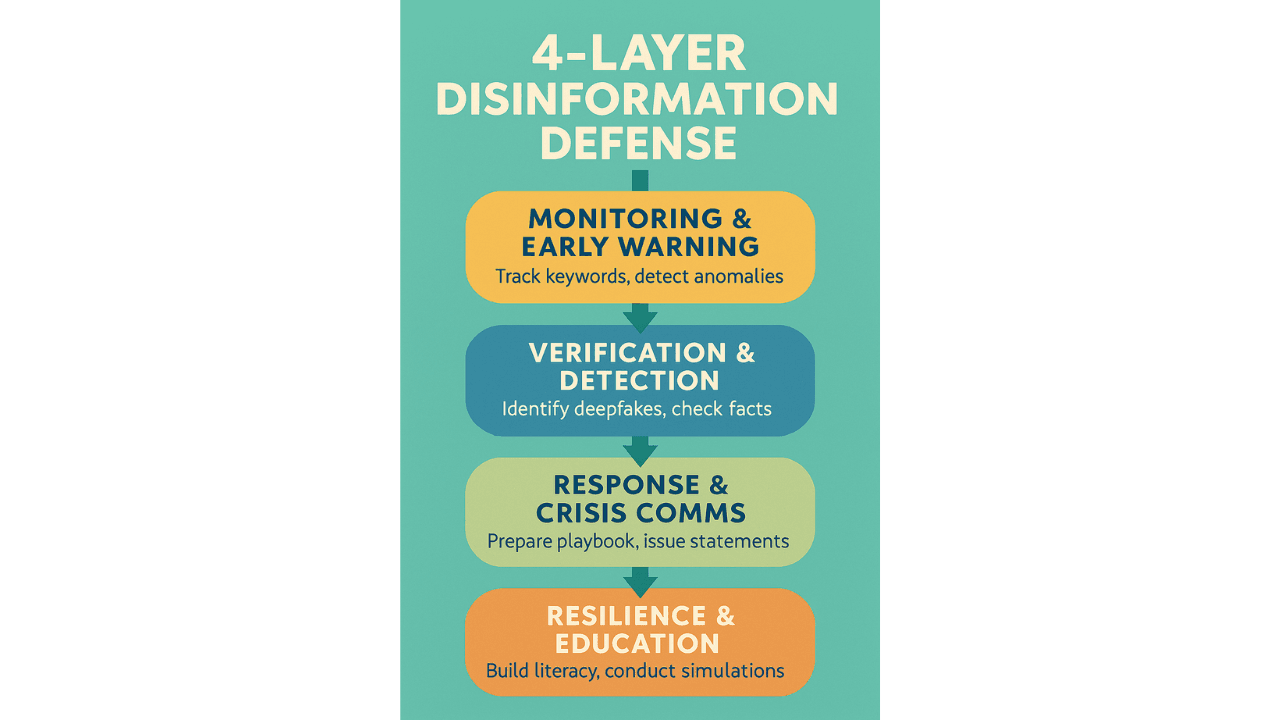

สถาปัตยกรรมป้องกันแบบ 4 ชั้น

1) Monitoring & Early Warning

- ตั้งคีย์เวิร์ด/แบรนด์เทอม เฝ้าระวังโซเชียล, ฟอรั่ม, และข่าว

- ใช้ระบบ anomaly detection ตรวจกราฟการแชร์/โทนความรู้สึก (sentiment) ที่ผิดปกติ

2) Verification & Detection

- ใช้โมเดลตรวจจับ deepfake (ภาพ/เสียง/วิดีโอ) และเช็คที่มาภาพ (metadata, hash)

- Fact-check อัตโนมัติ + human-in-the-loop ในเคสสำคัญ

3) Response & Crisis Comms

- เตรียม playbook: ใครอนุมัติข้อความ, ช่องทางสื่อสาร, SLA การตอบกลับ

- ออกแถลงการณ์โปร่งใส แนบหลักฐาน ตรวจย้อนกลับได้ (verifiable)

4) Resilience & Education

- สร้าง literacy ภายใน-ภายนอก: คู่มือแยกแยะข่าวปลอม, ตัวอย่าง deepfake

- Red teaming เชิงเนื้อหา: จำลองแคมเปญ disinformation แล้วซ้อมรับมือ

ตัวชี้วัด (KPI) ที่ควรติดตาม

- MTTD/MTTR ด้านข่าวปลอม: เวลาในการตรวจพบ/ตอบสนอง

- Coverage: % แหล่งเฝ้าระวังที่ครอบคลุม (ช่องทาง/ภาษา/ประเทศ)

- Brand Trust & Sentiment: แนวโน้มหลังเหตุการณ์

- False Positive/Negative: ความแม่นยำของระบบตรวจจับ

แนวทางปฏิบัติสำหรับองค์กร (Practical Playbook)

- กำหนด Data & Content Governance: นโยบายเผยแพร่, ลายเซ็นดิจิทัล, source of truth

- ตั้งทีม Response ข้ามฝ่าย: Comms, Legal, Security, Product, Exec

- เลือกเครื่องมือ AI ให้เหมาะ: monitoring, deepfake detection, fact-check API

- ทำ Tabletop Exercise รายไตรมาส: ซ้อมสถานการณ์จริงพร้อม postmortem

- เชื่อมความร่วมมือกับแพลตฟอร์ม/สำนักข่าว/ชุมชน fact-check

สำหรับบุคคลทั่วไป: เช็คก่อนแชร์

- ตรวจที่มา (แหล่งข่าว, ผู้โพสต์, วันเวลา) และเปรียบเทียบหลายสำนัก

- สังเกตสัญญาณ deepfake: ปาก/แสงเงา/กะพริบตา/เสียงผิดธรรมชาติ

- ระวังข้อความกระตุ้นอารมณ์จัด ๆ (ดีเกินจริง/ร้ายเกินจริง)

เช็กลิสต์ 7 ข้อก่อนแชร์

- ใครเป็นแหล่งข่าวต้นทาง? มีตัวตน/ความน่าเชื่อถือจริงหรือไม่

- มีวันที่/เวลาที่สอดคล้องกับเหตุการณ์หรือไม่ (ระวังข่าวเก่า)

- หัวข้อชวนอารมณ์พุ่งไหม—ลองอ่านตัวเนื้อหาจริงก่อน

- ภาพ/วิดีโอหาเจอต้นฉบับไหม (ลองค้นย้อนด้วยคีย์เวิร์ดหรือดูเมทาดาทา)

- มีสื่ออื่นรายงานตรงกันไหมอย่างน้อย 2–3 สำนัก

- มีหลักฐานอ้างอิง/ตัวเลขที่ตรวจสอบย้อนกลับได้หรือไม่

- ถ้าแชร์แล้วเกิดผลเสียกับคนหมู่มาก—มีเหตุผลมากพอหรือยัง

สรุป

Disinformation ในยุค AI ต้องรับมือแบบ ระบบทั้งองค์กร ผสานเครื่องมือ AI, กระบวนการสื่อสาร, และการสร้างภูมิคุ้มกันข้อมูล (Information Resilience). ทีมที่ชนะไม่ใช่ทีมที่ไม่มีเหตุการณ์ แต่คือทีมที่ ตรวจพบไว ตอบสนองไว และสื่อสารอย่างโปร่งใส.